|

Dr. Miguel Ángel Robles Universidad Privada Dr. Rafael Belloso Chacín, URBE miguel.robles@urbe.edu.ve

Post Doctor en Gerencia Pública y Gobierno. Post Doctor en Gerencia de Empresas. Dr. en Cs Gerenciales (URBE). M.Sc. en Gerencia de Empresas: mención Gerencia Financiera (LUZ). Licenciado en administración (UNER): mención Gerencia Industrial. Decano de Investigación y Postgrado de la Universidad Privada Dr. Rafael Belloso Chacín (URBE). PEII Nivel B. Líneas de Investigación: Finanzas y Operaciones. |

El empleo de estadística inferencial consiste en estudiar una muestra representativa de un colectivo, obteniendo conclusiones válidas para la totalidad. Para ello se emplea el análisis de varianza o ANOVA (por sus acrónimo Analysis of Variance), el cual es un método que se utiliza para comparar dos o más medias partiendo de una hipótesis sobre la igualdad de medias poblacionales. Cuando se comparan las varianzas muestrales es posible llegar a algunas conclusiones o inferencia de los valores relativos de las medias poblacionales.

El ANOVA se creó específicamente para probar si dos o más poblaciones tienen la misma media. Aun cuando el propósito de ANOVA es hacer pruebas para hallar las diferencias en las medias poblacionales, el mismo implica un examen de las varianzas muéstrales, de ahí el termino de análisis de varianza. El procedimiento se utiliza para determinar si cuando se aplica un tratamiento en particular a una población, este tendrá un impacto significativo en su media.

Asimismo, en los resultados obtenidos producto de la aplicación del Análisis de Varianza que forma parte de tratamiento estadístico inferencial es importante validar sus varianzas a través de la prueba de Levene, que complementa dicho tratamiento, el grado de semejanza o diferencia de las varianzas, ya que los elementos estudiados representados en los indicadores, dimensiones y variables son ponderados y susceptibles a la carencia tanto de normalidad como de homocedasticidad, para lo cual es necesario emplear pruebas de Post Hoc, como Tukey o cualquier otra cuando las varianzas son iguales; en el caso de que las varianzas no sean iguales se aplicara T3 de Dunnett o cualquier otro para cuando tenemos este resultado de desigualdad de varianzas.

Podemos concluir que el ANOVA se aplica con la finalidad de analizar las diferencias o semejanzas significativas tanto de las medias como de las varianzas, donde una alta o baja razón implicarían la aceptación o rechazo de la hipótesis, y por otro lado se revelara el efecto que tiene una variable sobre la otra de acuerdo a su población en cuanto a su grado de predictibilidad, a mayor o menor covarianza.

Criterios para aplicar el ANOVA

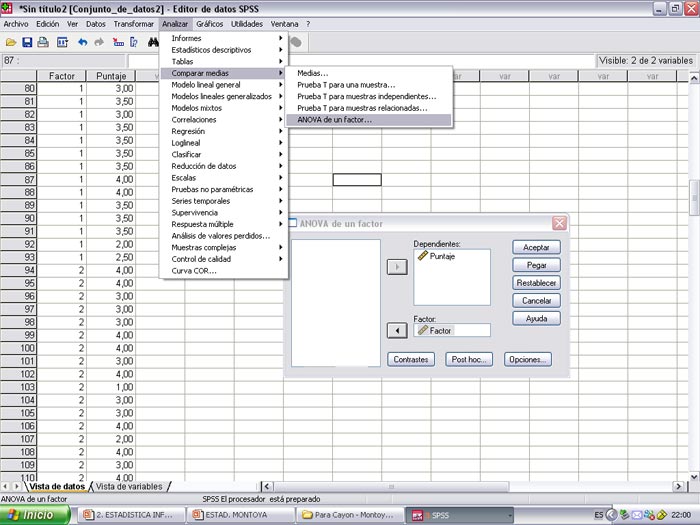

Para la aplicación del ANOVA ya existen programas que permiten realizar los análisis con solo cargar los datos en sus páginas y aplicar la herramienta de acuerdo a sus requerimientos, como es el caso del SPSS (Statistical Package for the Social Sciences) sin la necesidad de realizar cada una de las fórmulas para llegar al resultado final y así poder inferir de acuerdo a resultados de las fórmulas.